Süni intellekt

Süni intellekt (Sİ; ing. artificial intelligence, abr. AI) — insanların və ya heyvanların intellektindən fərqli olaraq maşın və ya proqram təminatının intellekti. Süni intellekt tətbiqlərinə qabaqcıl veb axtarış mühərrikləri (Quql axtarış sistemi), tövsiyə sistemləri ("YouTube", "Amazon" və "Netflix" tərəfindən istifadə olunur), virtual assistentlər ("Siri" və "Alexa" kimi), özügedən avtomobillər ("Waymo"), generativ və ya yaradıcı alətlər ("ChatGPT" və süni intellekt incəsənəti), strateji oyunlarda (şahmat və Qo kimi) ən yüksək səviyyədə yarışmaq daxildir.

Süni intellekt 1956-cı ildə akademik fənn kimi təsis edilmişdir. Bu sahə optimizm dövrlərindən keçmiş, sonradan məyusluq və maliyyə itkisi yaşamış, lakin 2012-ci ildən sonra dərin öyrənmə bütün əvvəlki süni intellekt üsullarını üstələmiş, beləliklə bu sahədə maliyyələşmə və maraqda böyük artım müşahidə edilmişdir.

Süni intellekt tədqiqatının müxtəlif alt sahələri xüsusi məqsədlər və xüsusi alətlərdən istifadə ətrafında cəmlənir. Süni intellekt tədqiqatının ənənəvi məqsədlərinə əsaslandırma, biliyin təqdim edilməsi, planlaşdırma, öyrənmə, təbii dilin emalı, qavrayış və robototexnikaya dəstək aiddir. Ümumi intellekt (ixtiyari problemi həll etmək bacarığı) sahənin uzunmüddətli hədəfləri arasındadır. Bu problemləri həll etmək üçün süni intellekt tədqiqatçıları axtarış və riyazi optimallaşdırma, formal məntiq, süni neyron şəbəkələri və statistika, ehtimal və iqtisadiyyata əsaslanan metodlar daxil olmaqla geniş spektrli problem həlli üsullarını uyğunlaşdırıb və inteqrasiya etmişdilər.

Simvolik süni intellekt

Simvolik süni intellekt — süni intellekt tədqiqatının bütün metodları, vəzifələrin, məntiqlərin və axtarışların yüksək səviyyədə "simvolik" (insan tərəfindən oxunan) təqdimatına əsaslanan bir addır. Simvolik Sİ, 1950-ci illərin ortalarından 1980-ci illərin sonlarına qədər Sİ tədqiqatının dominant paradiqmasının əsasını təşkil edirdi.

1985-ci ildə Con Hoqland, süni intellekt araşdırmalarının nəticələrinin fəlsəfi əks olunmasına həsr olunmuş kitabında simvolik Sİ-ə GOFAI (ing. Good Old-Fashioned Artificial Intelligence Artificial Intelligence: The Very Idea adını verdi. Robot texnikasında oxşar termin GOFAIR ("robototexnika sahəsində köhnə süni intellekt") istifadə olunur.

Simvolik AI-nin ən uğurlu forması istehsal qaydaları şəbəkəsini istifadə edən mütəxəssis sistemləridir. İstehsal qaydaları simvolları if-sonra operatoruna bənzər əlaqələrə birləşdirir. Bu qaydaları emal edən ekspert sistemi, məntiqi nəticələr çıxarır və əlavə məlumatların lazım olduğunu, yəni insan tərəfindən oxunan işarələrdən istifadə edərək hansı sualların verilməli olduğunu müəyyənləşdirir.

Süni intellektin yaranmasına simvolik yanaşma simvolların manipulyasiya yolu ilə zəkanın bir çox aspektinin başa düşülə və şərh oluna biləcəyi fərziyyəsinə əsaslanır. Bu fikir Newell-Simon hipotezinin əsasını təşkil etdi.

Süni intellekt (film)

Süni intellekt (ing. Artificial Intelligence: AI) — Brayan Oldisin «Super oyuncaqlar bütün yay yaşayırlar» (ing. Super-Toys Last All Summer Long) hekayəsi əsasında çəkilmiş Stiven Spilberqın elmi fantastik dram filmi.

«Ən yaxşı elmi fantastik filmi» naminasıyada «Saturn» mükafatı almış və 2002-ci ildə "Oskar" mükafatda «Ən yaxşı vizual effektlərə görə» nominasiyada göstərilmiş, lakin mükafatı almadı.

Stenli Kubrik «Super oyuncaqlar bütün yay yaşayırlar» hekayəsinin adoptasiyası üzərində onun müəllifi Brayan Oldisi işə alıb, gec 70-ci illərdən başlayaraq işləyirdi. 1985-ci ildə Kubrik Stilberqdən filmin rejissoru olmağa təklif edib, özü isə onun prodüseri olmaq istəyirdi. Warner Bros. bu filmə əlavə sponsorluq etmək və onu yayımlamağa razılaşıb.

Süni intellekt etikası

Süni intellekt etikası — robotlar və digər süni şəkildə ağıllı canlılar üçün xarakterik olan texnologiya etikasının bir hissəsi. Süni əqli varlıqların dizaynı, qurulması, istifadəsi və müalicəsi, süni əxlaqi agentlərin (IMA) əxlaqi davranışına aid maşın etikası məsələlərini həll edən ümumiyyətlə roboetika bölünür.

"Robot etikası" termini (və ya "roboetika") insanların robotları və digər süni şəkildə yaradılan ağıllı varlıqları necə tərtib etməsi, qurması, istifadəsi və idarə etmələrinin mənəvi məsələlərinə aiddir. Süni şəkildə yaradılan ağıllı varlıqların insanların ziyanına və mənafeyinə necə istifadə olunacağından bəhs edir.

"Robot Hüquqları", insanların maşınları qarşısında insan hüquqları və ya heyvanlara bənzər bir mənəvi öhdəliklərə sahib olmaları lazım olan bir anlayışdır. Mövcud olmaq və öz missiyasını yerinə yetirmək hüququ kimi robotların hüquqlarının insan hüquqlarının cəmiyyət qarşısında insan öhdəlikləri ilə əlaqələndirilməsi ilə bir insana xidmət etmək vəzifəsi ilə əlaqələndirilə biləcəyinə dair bir təklif var. Bunlara həyat və azadlıq hüququ, fikir və ifadə azadlığı, habelə qanun qarşısında bərabərlik də daxil ola bilər. Bu məsələ Gələcək İnstitutu və İngiltərə Ticarət və Sənaye Departamenti tərəfindən həll edilmişdir.

Mütəxəssislərin yaxın gələcəkdə və ya yalnız uzaq gələcəkdə konkret və detallı qanunların tələb olunacağına dair ümumi bir fikri yoxdur. Qlenn MakGi, kifayət qədər humanoid robotların 2020-ci ilə qədər görünə biləcəyini bildirir.

Süni intellekt fəlsəfəsi

Süni intellekt fəlsəfəsi — idrak fəlsəfəsinin və informatika fəlsəfəsinin qolu. Burada süni intellekt və onun intellekt, etika, şüur, epistemologiya və azad iradənin biliyə təsirini araşdırır. Bundan əlavə, texnologiya süni heyvanların və ya süni insanların (və ya ən azı süni varlıqların) yaradılması ilə məşğuldur. Bu səbəbə görə sözügedən fənn filosoflar üçün böyük maraq doğurur. Bu amillər süni intellekt fəlsəfəsinin yaranmasına səbəb olmuşdur.

Süni intellekt fəlsəfəsi bu kimi suallara cavab verməyə çalışır:

Maşın ağıllı hərəkət edə bilərmi? İnsanın düşünərək həll edəcəyi hər hansı problemi həll edə bilərmi?

İnsan zəkası və maşın zəkası eynidirmi? İnsan beyni əslində kompüterdirmi?

Maşın bir insan kimi idrak, psixi vəziyyət və şüura malik ola bilərmi?

Süni intellekt bumu

Süni intellekt bumu (ing. AI boom) — süni intellekt sahəsində davam edən sürətli və görünməmiş inkişaf dövrü. Generativ süni intellekt yarışı 2016 və ya 2017-ci ildə OpenAI-nin yaradılması ilə ciddi şəkildə başlayan bu bumun əsas komponentidir. OpenAI-nin yaradıcı AI sistemləri, məsələn müxtəlif GPT modelləri (2018-ci ildən başlayaraq) və DALL-E (2021) bunun idarə edilməsində mühüm rol oynamışdır.

2022-ci ildə böyük dil modelləri çatbot tətbiqləri üçün istifadə oluna biləcək şəkildə təkmilləşdirildi. Mətndən şəklə çevirən modellər elə bir nöqtədə idi ki, yaratdıqları insan tərəfindən yaradılmış təsvirlərdən demək olar ki fərqlənmirdi və nitq sintezi proqramı insan nitqini səmərəli şəkildə təkrarlaya bilirdi.

2022-ci ilin sonu və 2023-cü il ərzində onlarla yeni veb-sayt və AI çatbotları ortaya çıxdı, çünki Big Tech bazarda möhkəmlənməyə çalışırdı və süni intellekt alətlərinin hər yerdə görünməmiş artımına səbəb oldu.

Süni intellekt bumuna ictimai reaksiya qarışıq olub, bəzi tərəflər süni intellektin yaratdığı yeni imkanları, onun bəşəriyyətə fayda gətirmək potensialını və mükəmməlliyini tərifləyir, digər tərəflər isə onu iş təhlükəsizliyini təhdid etdiyinə, cavablarında "anlaşılmaz" olduğuna və proqramlaşdırma suallarına səhv cavab verməsinə görə qınayıblar.

GPT-3, OpenAI tərəfindən 2020-ci ildə yayımlanan insan tərəfindən yazıldığını müəyyən etmək çətin olan yüksək keyfiyyətli mətn yaratmağa qadir olan böyük bir dil modelidir. ChatGPT-də GPT-3.5 adlı təkmilləşdirilmiş versiyadan istifadə edilib.

Hökumətdə süni intellekt

Hökumətdə süni intellekt — süni intellektin (Sİ) hökumətdə bir çox sahədə istifadəsini əhatə edən ifadə. Bu, dövlət siyasəti hədəflərinə çatmaq (təcili yardım xidmətləri, səhiyyə və rifah kimi sahələrdə), eləcə də ictimaiyyətə hökumətlə qarşılıqlı əlaqədə kömək etmək üçün istifadə edilir. "Harvard Business Review"a görə, "bütün dünyada aparılan ilkin təcrübələrlə süni intellektin dövlət sektoruna tətbiqi genişlənir və böyüyür". Harvard Universitetinin Eş Demokratik İdarəetmə və İnnovasiya Mərkəzindən Hila Mehr qeyd etmişdir ki, hökumətdə süni intellekt yeni deyil, poçt xidmətləri 1990-cı illərin sonlarında məktubları avtomatik yönləndirmək məqsədilə zərflərdəki əlyazmanı tanımaq üçün maşın üsullarından istifadə edir. Hökumətdə süni intellektdən istifadə əhəmiyyətli faydalar, o cümlədən xərclərə qənaət (məsələn, ofis işçilərinin sayını azaltmaqla) və korrupsiya imkanlarının azaldılması ilə nəticələnən səmərəlilik gətirir.

Hökumətdə süni intellektdən istifadə imkanları geniş və müxtəlifdir. "Deloitte" hesab edir ki, "İdrak texnologiyaları nəhayət hökumət əməliyyatlarının hər bir aspektində inqilab edə bilər".

Mehr qeyd etmişdir ki, "Dövlət işində süni intellekt tətbiqləri özəl sektorda süni intellektin sürətlə genişlənməsi ilə ayaqlaşmasa da, dövlət sektorundakı potensial istifadə halları özəl sektordakı ümumi tətbiqləri əks etdirir".

Süni intellektin dövlət siyasətinin məqsədlərinə töhfə verə biləcəyi bir sıra nümunələr var. Bunlara daxildir:

İş yerini itirdikdə, təqaüdə çıxdıqda, ailəni itirdikdə və uşaq doğulduqda müavinətlərin demək olar ki, dərhal, avtomatlaşdırılmış şəkildə alınması (beləliklə, bunun vətəndaşlardan heç bir hərəkət tələb etmədən həyata keçirilməsi)

Sosial sığorta xidmətlərinin göstərilməsi

Təcili çağırışların təcililiyinə görə təsnifləşdirilməsi

Xəstəliklərin aşkarlanması və yayılmasının qarşısının alınması

Dövlət qulluqçularına sosial ödənişlərin və immiqrasiya qərarlarının qəbulunda köməklik göstərilməsi

Girovla bağlı dinləmələrə qərar verilməsi

Səhiyyə ilə bağlı işlərin araşdırılması

Siyasətlərə dair ictimai rəy üçün sosial medianın monitorinqi

Fövqəladə halları müəyyən etmək üçün sosial medianın monitorinqi

Saxta müavinət iddialarının müəyyən edilməsi

Cinayətin proqnozlaşdırılması və optimal polis mövcudluğunun tövsiyə edilməsi

Tıxacların və avtomobil qəzalarının proqnozlaşdırılması

Yolun təmiri tələblərinin proqnozlaşdırılması

Sağlamlıq qaydalarının pozulmasının müəyyən edilməsi

Tələbələrə fərdi təhsilin verilməsi

İmtahan sənədlərinin qiymətləndirilməsi

Müdafiə və milli təhlükəsizliyə yardım

Simptomlara əsaslanan sağlamlıq çatbotu "AI Vaid"-in diaqnozlar üçün hazırlanması

Hökumətdə Sİ-nin digər istifadələrinə aşağıdakılar daxildir:

Tərcümə

Avropa Komissiyasının Tərcümə üzrə Baş Direktorluğu və Florika Fink-Hoyyer tərəfindən hazırlanmış sinxron tərcümə.

Dost süni intellekt

Dost süni intellekt — bəşəriyyətə müsbət (zərərsiz) təsir göstərəcək və ya ən azı insan maraqları ilə üst-üstə düşəcək və ya insan növünün təkmilləşdirilməsinə töhfə verəcək hipotetik süni ümumi intellekt. Bu, süni intellekt etikasının bir hissəsidir və maşın etikası ilə sıx əlaqəlidir. Maşın etikası süni intellekt agentinin necə davranması ilə məşğul olsa da, dost süni intellekt araşdırmaları bu davranışı praktik olaraq necə həyata keçirməyə və onun adekvat şəkildə məhdudlaşdırılmasını təmin etməyə yönəlib.

Bu termin insani dəyərləri etibarlı şəkildə həyata keçirən superintellekt süni agentləri müzakirə etmək ideyasını populyarlaşdırması ilə tanınan Eliezer Yudkovski tərəfindən icad edilmişdir. Stüart Rassel və Piter Norviqin aparıcı süni intellekt kitabı olan "Süni intellekt: Müasir yanaşma" ideyanı belə təsvir edir:

"Dost" bu kontekstdə texniki terminologiya kimi istifadə olunur və danışıq mənasında "dost" olanları deyil, təhlükəsiz və faydalı agentləri seçir. Konsepsiya ilk növbədə zəkada sürətlə partlayan rekursiv şəkildə özünü təkmilləşdirən süni agentlərin müzakirələri kontekstində, bu hipotetik texnologiyanın insan cəmiyyətinə böyük, sürətli və idarə olunması çətin təsir göstərəcəyinə əsaslanaraq istifadə olunur.

Yudkowsky, E. Artificial Intelligence as a Positive and Negative Factor in Global Risk. In Global Catastrophic Risks, Oxford University Press, 2008.Discusses Artificial Intelligence from the perspective of Existential risk. In particular, Sections 1-4 give background to the definition of Friendly AI in Section 5. Section 6 gives two classes of mistakes (technical and philosophical) which would both lead to the accidental creation of non-Friendly AIs.

Generativ süni intellekt

Generativ süni intellekt — generativ modellərdən istifadə edərək mətn, şəkil və ya digər media yarada bilən süni intellekt. Generativ süni intellekt modelləri daxil edilmiş təlim məlumatlarının nümunələrini və strukturunu öyrənir və sonra oxşar xüsusiyyətlərə malik yeni məlumatlar yaradır.

2020-ci illərin əvvəllərində transformer əsaslı dərin neyron şəbəkələrindəki irəliləyişlər təbii dil göstərişlərini daxil edilən mətn kimi qəbul edən bir sıra generativ Sİ sistemlərini işə saldı. Bunlara ChatGPT, Copilot, Bard və LLaMA kimi böyük dil modeli çatbotları və Stable Diffusion, Midjourney və DALL-E kimi mətndən-şəklə süni intellekt sənət sistemləri daxildir.

Generativ süni intellekt incəsənət, yazı, ssenari, proqram təminatının inkişafı, məhsul dizaynı, səhiyyə, maliyyə, oyun, marketinq və dəb daxil olmaqla geniş sənaye sahələrində istifadə edilir. 2020-ci illərin əvvəllərində Microsoft, Google və Baidu kimi böyük şirkətlər, eləcə də generativ süni intellekt modellərini inkişaf etdirən çoxsaylı kiçik şirkətlər sayəsində generativ süni intellektə investisiyalar artdı. Bununla belə, kibercinayətkarlıq və ya insanları aldatmaq və ya manipulyasiya etmək üçün istifadə edilə bilən saxta xəbərlər və ya deepfake-lər yaratmaq da daxil olmaqla, generativ Sİ-nin potensial sui-istifadəsi ilə bağlı narahatlıqlar da var.

Süni intellektin akademik intizamı 1956-cı ildə Dartmut Kollecində tədqiqat emalatxanasında qurulmuşdur və o vaxtdan bəri bir sıra irəliləyiş və optimizm dalğaları yaşamışdır. Yarandığı gündən bu sahədə tədqiqatçılar insan şüurunun təbiəti və insana bənzər intellektə malik süni varlıqların yaradılmasının nəticələri haqqında fəlsəfi və etik arqumentlər irəli sürmüşlər. Bu məsələlər daha əvvəl antik dövrdən bəri mif, bədii ədəbiyyat və fəlsəfə tərəfindən araşdırılmışdır.

Hallüsinasiya (süni intellekt)

Süni intellektin hallüsinasiyası — süni intellekt tərəfindən fakt kimi təqdim edilən yalan və ya çaşdırıcı məlumatları ehtiva edən cavab.

Məsələn, hallüsinasiya edən bir çatbotdan şirkət üçün maliyyə hesabatı hazırlamaq istənildikdə, yanlış olaraq şirkətin gəlirinin 13,6 milyard dollar olduğunu göstərə bilər. Bu cür hadisələr insan psixologiyasındakı hallüsinasiya fenomeni ilə bənzədilərək "hallüsinasiyalar" adlanır. Bununla belə, əsas fərqlərdən biri odur ki, insan hallüsinasiyası adətən yanlış qavrayışlarla əlaqələndirilir, lakin Sİ halüsinasiyası əsassız cavablar və ya inanclar kateqoriyası ilə əlaqələndirilir. Bəzi tədqiqatçılar hesab edirlər ki, xüsusi "Sİ hallüsinasiyası" termini əsassız olaraq kompüterləri antropomorflaşdırır.

Süni intellekt hallüsinasiyası 2022-ci ildə ChatGPT kimi müəyyən böyük dil modellərinin (LLM) tətbiqi ilə ortaya çıxdı. İstifadəçilər şikayət edirdilər ki, bu cür çatbotlar çox vaxt yaratdıqları məzmuna ağlabatan səslənən təsadüfi yalanları mənasız şəkildə yerləşdirirlər. 2023-cü ilə qədər analitiklər hallüsinasiyaları LLM texnologiyasında əsas problem hesab edirdilər. Bəzi təxminlərə görə çatbotların hallüsinasiya "görmə" ehtimalı 27%-dir.

Wired tərəfindən sitat gətirilən müxtəlif tədqiqatçılar rəqib hallüsinasiyaları yüksək ölçülü statistik hadisə kimi təsnif etmişlər və ya hallüsinasiyaları kifayət qədər təlim məlumatlarının olmaması ilə əlaqələndirmişlər.

Süni intellekt təhlükəsizliyi

Süni intellekt təhlükəsizliyi — süni intellekt (Sİ) sistemləri nəticəsində yarana biləcək qəzaların, sui-istifadənin və ya digər zərərli nəticələrin qarşısının alınması ilə əlaqəli fənlərarası sahə. O, süni intellekt sistemlərini əxlaqlı və faydalı etmək məqsədi daşıyan maşın etikasını və süni intellektin uyğunlaşdırılmasını, süni intellekt təhlükəsizliyi isə risklərin monitorinqi sistemləri və onların daha etibarlı vəziyyətə gətirilməsi də daxil olmaqla texniki problemləri əhatə edir. Süni intellektlə bağlı araşdırmalardan əlavə, bu, təhlükəsizliyi təşviq edən norma və siyasətlərin işlənib hazırlanmasını da nəzərdə tutur.

Süni intellekt tədqiqatçılarının süni intellekt texnologiyasının yaratdığı riskin şiddəti və əsas mənbələri haqqında çox fərqli fikirləri var, baxmayaraq ki, sorğular ekspertlərin yüksək nəticəli riskləri ciddi qəbul etdiyini göstərir. Süni intellekt tədqiqatçılarının iki sorğusunda, iştirakçılar ortaq fikir olaraq ümumilikdə süni intellektə nikbin baxıb, lakin qabaqcıl süni intellektin "çox pis (məsələn, bəşəriyyətin məhvi)" nəticəsinə 5% ehtimal verib. 2022-ci ildə "Natural Language Processing" (NLP) icmasının sorğusunda iştirakçıların 37%-i süni intellektlə bağlı qərarların "ən azı nüvə müharibəsi qədər pis" fəlakətə səbəb ola biləcəyi fikri ilə tam və qismən razılaşıb. Alimlər kritik sistem uğursuzluqları, qərəzlilik və süni intellektlə işləyən müşahidədən yaranan cari riskləri, texnoloji işsizlikdən, rəqəmsal manipulyasiyadan və silahlaşdırmadan yaranan riskləri və gələcək süni ümumi intellekt (SÜİ) agentlərinə nəzarəti itirməkdən yaranan spekulyativ riskləri müzakirə edirlər.

Bəziləri, 2015-ci ildə onları "Marsa hələ ayaq basmamış əhalinin aşırı çoxluğundan narahat olmaq" ilə müqayisə edən Endryu In kimi SÜİ ilə bağlı narahatlıqları tənqid etdi. Digər tərəfdən Stüart Rassel, "insan ixtirasını az qiymətləndirməkdənsə, onu təxmin etmək daha yaxşıdır" deyərək ehtiyatlı olmağa çağırır.

Süni ümumi intellekt

Süni ümumi intellekt (SÜİ) — ağıllı agentin hipotetik növü. Reallaşdırıldığı təqdirdə, SÜİ insanların və ya heyvanların yerinə yetirə biləcəyi hər hansı bir intellektual tapşırığı yerinə yetirməyi öyrənə bilər. Alternativ olaraq, SÜİ iqtisadi cəhətdən dəyərli işlərin əksəriyyətində insan imkanlarını üstələyən avtonom sistem kimi müəyyən edilmişdir. SÜİ yaratmaq bəzi süni intellekt tədqiqatlarının və OpenAI, DeepMind və Anthropic kimi şirkətlərin əsas məqsədidir. SÜİ elmi fantastika və futurologiya tədqiqatlarının ümumi mövzusudur.

SÜİ-nin inkişafı üçün vaxt qrafiki tədqiqatçılar və ekspertlər arasında davamlı müzakirə mövzusu olaraq qalır. Bəziləri bunun illər və ya onilliklər ərzində mümkün ola biləcəyini iddia edir; başqaları bunun bir əsr və ya daha çox çəkə biləcəyini iddia edir; azlıq bir qisim isə buna heç vaxt nail oluna bilməyəcəyinə inanır. SÜİ-nin dəqiq tərifi və GPT-4 kimi müasir böyük dil modellərinin (LLM) SÜİ-nin erkən, lakin natamam formaları olub-olmaması ilə bağlı mübahisələr yaranmışdır.

SÜİ-nin bəşəriyyət üçün təhlükə yaratma potensialı da mübahisə mövzusudur. Məsələn, OpenAI buna ekzistensial risk kimi yanaşır, digərləri isə SÜİ-nin inkişafını riskdən çox uzaq hesab edir.

Videooyunlarda süni intellekt

Videooyunlarda süni intellekt — süni intellekt qeyri-oyunçu personajlarına olduqları vəziyyəti təhlil etmək və məntiqli qərarlar qəbul etmək imkanı vermək üçün süni intellektin video oyunlarına köçürülməsi cəhdidir. 1950-ci illərdə ortaya çıxan süni intellekt, hazırda video oyunlar üçün ayrı bir AR-GE prosesinə malikdir və süni intellektin akademik sahəsindən fərqlənir. Maşın öyrənməsinə diqqət yetirən akademik inkişaf sahəsindən fərqli olaraq, oyunçu təcrübəsini yaxşılaşdırmağa xidmət edir.

Yaradıcı süni intellekt

Generativ süni intellekt — generativ modellərdən istifadə edərək mətn, şəkil və ya digər media yarada bilən süni intellekt. Generativ süni intellekt modelləri daxil edilmiş təlim məlumatlarının nümunələrini və strukturunu öyrənir və sonra oxşar xüsusiyyətlərə malik yeni məlumatlar yaradır.

2020-ci illərin əvvəllərində transformer əsaslı dərin neyron şəbəkələrindəki irəliləyişlər təbii dil göstərişlərini daxil edilən mətn kimi qəbul edən bir sıra generativ Sİ sistemlərini işə saldı. Bunlara ChatGPT, Copilot, Bard və LLaMA kimi böyük dil modeli çatbotları və Stable Diffusion, Midjourney və DALL-E kimi mətndən-şəklə süni intellekt sənət sistemləri daxildir.

Generativ süni intellekt incəsənət, yazı, ssenari, proqram təminatının inkişafı, məhsul dizaynı, səhiyyə, maliyyə, oyun, marketinq və dəb daxil olmaqla geniş sənaye sahələrində istifadə edilir. 2020-ci illərin əvvəllərində Microsoft, Google və Baidu kimi böyük şirkətlər, eləcə də generativ süni intellekt modellərini inkişaf etdirən çoxsaylı kiçik şirkətlər sayəsində generativ süni intellektə investisiyalar artdı. Bununla belə, kibercinayətkarlıq və ya insanları aldatmaq və ya manipulyasiya etmək üçün istifadə edilə bilən saxta xəbərlər və ya deepfake-lər yaratmaq da daxil olmaqla, generativ Sİ-nin potensial sui-istifadəsi ilə bağlı narahatlıqlar da var.

Süni intellektin akademik intizamı 1956-cı ildə Dartmut Kollecində tədqiqat emalatxanasında qurulmuşdur və o vaxtdan bəri bir sıra irəliləyiş və optimizm dalğaları yaşamışdır. Yarandığı gündən bu sahədə tədqiqatçılar insan şüurunun təbiəti və insana bənzər intellektə malik süni varlıqların yaradılmasının nəticələri haqqında fəlsəfi və etik arqumentlər irəli sürmüşlər. Bu məsələlər daha əvvəl antik dövrdən bəri mif, bədii ədəbiyyat və fəlsəfə tərəfindən araşdırılmışdır.

Azərbaycan Süni İntellekt Laboratoriyası

Azərbaycan Süni İntellekt Laboratoriyası — Rəqəmsal İnkişaf və Nəqliyyat Nazirliyi (Azərbaycan)nin nəznində əsası qoyulan Azərbaycan Süni İntellekt Laboratoriyası, süni intellektin inkişafı və milli süni intellekt fəaliyyətinin, qabiliyyətinin çevik idarə olunmasını məqsədilə yaradılmışdır.

Süni intellektlə idarə olunan gələcək üçün lazım olan qabiliyyətləri inkişaf etdirmək, bacarıqlı kadr hazırlamaq üçün innovativ infrastruktur, Azərbaycan Süni İntellekt Laboratoriyasının tərkibində yaradılıb. Əsas məqsəd isə bu sahə üzrə tədqiqat və inkişafı artırmaq, istedadların inkişafı üçün texniki bacarıq təlimləri və məqsədyönlü seminarlar təşkil etməkdir. Süni intellekt laboratoriyası bu səhənin imkanlarından tam istifadə etmək üçün sənaye tərəfdaşları, innovativ şirkətlər və akademik institutlarla əməkdaşlıq edilir.

Həmçinin uzunmüddətli perspektivdə süni intellekt imkanlarını genişləndirmək və tam şəkildə istifadə etmək üçün təlimlər, təlim düşərgələri, vebinarlar, konfranslar və məqsədyönlü seminarlar kimi bir sıra geniş fəaliyyətlər təşkil etməyi və iştirak etməyi planlayır.

Platforma süni intellektlə idarə olunan və gələcək üçün lazım olan qabiliyyətləri inkişaf etdirmək üçün elmi-tədqiqat və təkmilləşdirmə və istedadların inkişafı üçün sənaye-akademiya tərəfdaşlığının artırılmasına yönəlmişdir.

Laboratoriya aşağıdakı istiqamətlərdə fəaliyyət göstərir:

Cari təşkilati və sosial problemlərin tədqiqi və müəyyənləşdirilməsi;

Süni intellekt modellərinin və tətbiqlərinin yaradılması və təbliği;

Süni intellekt və Böyük Data üzrə təlimlərin keçirilməsi;

Rəqəmsal transformasiyanı gücləndirmək üçün özəl və dövlət sektorunun ehtiyacı olan süni intellekt tətbiqi sahəsində peşəkar dəstək və təlimatı təmin etmək;

Sahibkarlıqda, xüsusilə tədqiqatın və inkişafın artırılmasında, innovasiya potensialının artırılmasında dəstək göstərmək.

İntellekt

İntellekt (ing. intelligence ~ ru. интеллект, интеллектуальный ~ tr. zeka, zeki) İntellekt sözü Latın mənşəlidir: intellectus – başa düşmə, intellegere – başa düşmək, inter – arasında, legere – seçmək. 1. Kompüterin aparat vasitələrinə aid işlədildikdə: informasiyanı emal etmək bacarığı. İntellektuallıq bütün kompüterlərin və özlərinin verilənləri emal edən vasitələri olan periferiya qurğularının xüsusiyyətdir. İntellektual olmayan qurğu, necə deyərlər, "düşüncəsiz" olur, məsələn, böyük kompüterlə bağlı olan giriş-çıxış monitoru verilənləri daxil edə və onları çıxara bilir, ancaq informasiyanı sərbəst emal edə bilmir. 2. Proqram təminatına aid işlədildikdə: sistemin durumunu izləmək və arzu olunan nəticəni almaq üçün proqramın müvafiq əməliyyatlar yaratmaq bacarığı.

Aİ-nin Süni intellekt haqqında Qanunu

Süni intellekt haqqında Qanun, Aİ-nin Süni intellekt haqqında Qanunu və ya Avropa İttifaqının Süni intellekt haqqında Qanunu (ing. Artificial Intelligence Act) — süni intellekt haqqında Avropa İttifaqının reqlamenti.

Bu Qanun Avropa İttifaqı daxilində süni intellektlə bağlı ümumi tənzimləyici və normativ baza yaradır. Avropa Komissiyası tərəfindən 21 aprel 2021-ci ildə təklif edilmiş qanun layihəsi 13 mart 2024-cü ildə Avropa Parlamentində oxunuşdan keçmiş və 21 may 2024-cü ildə Avropa İttifaqı Şurası tərəfindən yekdilliklə təsdiq edilmişdir. Qanun həmçinin milli əməkdaşlığı təşviq etmək və reqlamentə riayət olunmasını təmin etmək məqsədilə Avropa Süni İntellekt Şurasının yaradılmasını da nəzərdə tutur.

Qanun yalnız hərbi, milli təhlükəsizlik, tədqiqat və qeyri-peşəkar məqsədlər üçün istifadə edilən süni intellekt sistemləri istisna olmaqla, qalan sahələr üzrə bütün növ süni intellekt sistemlərini əhatə edir. Qanun məhsul tənzimləməsinin bir hissəsi kimi fərdlərə hüquqlar verilməsini nəzərdə tutmur və sadəcə süni intellektdən peşəkar kontekstdə istifadə edən qurumların və süni intellekt sistem provayderlərinin fəaliyyətini tənzimləyir. Qanun layihəsinin ilkin versiyası ChatGPT kimi generativ süni intellekt sistemlərinin ümumi təyinatlı imkanlarına uyğun gəlmədiyinə görə həmin proqramların populyarlığının artmasını da nəzərə alaraq yenidən işlənmişdir. Bununla da sistematik təsiri olan güclü generativ süni intellekt sistemləri üçün daha məhdudlaşdırıcı qaydaların qəbulu planlaşdırılmışdır.

Qanun bu aktın tənzimetmə predmetinə daxil olan süni intellekt tətbiqlərini onların zərər vurma riskinə görə təsnif edir.

Sosial intellekt

Sosial intellekt — özünü və başqalarını tanıma qabiliyyəti, cisimləri və ya səsləri bilmək qabiliyyəti kimi humanitar şərtlərin əvəzsiz bir hissəsidir və bir çox cəhətdən araşdırılmağa dəyər. Sosioloq Ross Hanivillə görə, sosial intellekt sosial inancları, münasibətləri və mürəkkəb sosial dəyişikliyi idarə etmək qabiliyyətini inkişaf etdirən özünün və sosial şüurun kollektiv bir ölçüsüdür.

Psixoloq Nikolas Hamfrey insan olaraq kim olduğumuzu müəyyən etmənin kəmiyyət ağlından başqa ictimai ağıl olduğunu irəli sürmüşdür.

Edvard Torndayk 1920-ci ildə ictimai ağıl anlayışını böyük kişilər və qadınları, gənc kişilər və qızları, insan münasibətlərində müdrik olmağı anlamaq və idarə etmək bacarığı olaraq izah etdi. Bu Hovard Gardnerin çoxsaylı intellekt nəzəriyyəsində təsvir olunan insanlararası ağıla bərabərdir və zehin nəzəriyyəsi ilə sıx əlaqəlidir. Bəzi müəlliflər sosial intellekt tərifini yalnız sosial-psixoloji reklam və marketinq strategiyalarına baxaraq sosial vəziyyət haqqında məlumatlı olmaq şəklində bildirmişdilər. Şon Folenoya görə sosial intellekt, fərdin ətraf mühiti ən yaxşı şəkildə başa düşmək və uğurlu sosial davranışa müvafiq reaksiya vermək bacarığıdır.

Sosial intellektin qabiliyyət, şifahi və qeyri-şifahi işarələri oxumaq, məlumatdan istifadə etmək, insanları məlumatlandırmaq kimi bir çox fərqli komponentə sahib olduğu müşahidə edilmişdir. Sosial qarşılıqlı əlaqələrdə bacarıqlı olan şəxslərin emosiyalarına nəzarət etmərində də müvəffəq olduqları müəyyənləşdirilmişdir. Bundan əlavə, empatiya sosial zəka quruluşunun tərkib hissəsi olaraq ortaya çıxır.

İntellekt (psixologiya)

İntellekt (ing. intelligence ~ ru. интеллект, интеллектуальный ~ tr. zeka, zeki) İntellekt sözü Latın mənşəlidir: intellectus – başa düşmə, intellegere – başa düşmək, inter – arasında, legere – seçmək. 1. Kompüterin aparat vasitələrinə aid işlədildikdə: informasiyanı emal etmək bacarığı. İntellektuallıq bütün kompüterlərin və özlərinin verilənləri emal edən vasitələri olan periferiya qurğularının xüsusiyyətdir. İntellektual olmayan qurğu, necə deyərlər, "düşüncəsiz" olur, məsələn, böyük kompüterlə bağlı olan giriş-çıxış monitoru verilənləri daxil edə və onları çıxara bilir, ancaq informasiyanı sərbəst emal edə bilmir. 2. Proqram təminatına aid işlədildikdə: sistemin durumunu izləmək və arzu olunan nəticəni almaq üçün proqramın müvafiq əməliyyatlar yaratmaq bacarığı.

İntellekt nisbəti

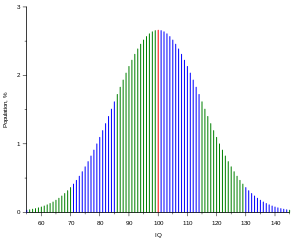

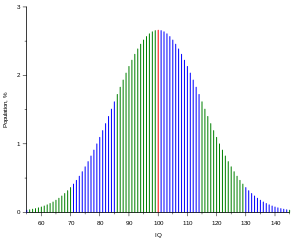

İntellekt əmsalı (ing. intelligence quotient; abr. IQ ; təl. "ay-kü") — insanın malik olduğu intellekt qabiliyyətinin kəmiyyət göstəricisi.

Verilmiş şəxs eyni zamanda cəmiyyətdə orta statistik insanın malik olduğu intellektə nisbətən müqayisə olunur. Bunun üçün xüsusu testlər mövcuddur. IQ testləri bilik səviyyəsini yox, düşünmə qabiliyyətini aşkar etməyə xidmət edir. İntellekt əmsalı ümumi intellekt faktorunun (g) qiymətləndirilməsi üçün tətbiq edilir.

İQ testləri elə tərtib edilir ki, nəticəni mərkəzi 100%-ə bərabər İQ qiyməti olan normal səpələnmə kimi təsvir etmək mümkün olsun, belə ki, insanların 50%-i 90–110 arasında, 25%-i isə 110-dan artıq qiymətə malik olsunlar. Amerika ali məktəbinin məzununun İQ qiyməti 115, əlaçıların ki, isə 135–140 təşkil edir.

İntellekt testləri

İntellekt testləri - yoxlananların əqli inkişaf səviyyəsini aşkara çıxarmağa xidmət edir.

İntellekt testləri haqqında ilk fikir F.Qalton (1822-1911) tərəfindən irəli sürülmüşdür. Sonralar fransız psixoloqu A.Bine ilk psixoloji testləri yaratmışdır (1905-ci il). Hal – hazırda psixodiaqnostik tədqiqatlarda D.Vekslerin şkalasından, «proqressiv Raven matrisasından», R.Amtxauerin əqlin (intellektin) strukturu testindən, Q.Y.Ayzenqin «öz qabiliyyətlərinizi yoxlayın», «özünüzün əqli inkişaf koeffisentinizi yoxlayın» və s. geniş istifadə olunur.

Ümumi psixologiya. Prof. S.İ.Seyidov və prof. M.Ə.Həmzəyevin elmi redaktorluğu ilə.

İntellekt əmsalı

İntellekt əmsalı (ing. intelligence quotient; abr. IQ ; təl. "ay-kü") — insanın malik olduğu intellekt qabiliyyətinin kəmiyyət göstəricisi.

Verilmiş şəxs eyni zamanda cəmiyyətdə orta statistik insanın malik olduğu intellektə nisbətən müqayisə olunur. Bunun üçün xüsusu testlər mövcuddur. IQ testləri bilik səviyyəsini yox, düşünmə qabiliyyətini aşkar etməyə xidmət edir. İntellekt əmsalı ümumi intellekt faktorunun (g) qiymətləndirilməsi üçün tətbiq edilir.

İQ testləri elə tərtib edilir ki, nəticəni mərkəzi 100%-ə bərabər İQ qiyməti olan normal səpələnmə kimi təsvir etmək mümkün olsun, belə ki, insanların 50%-i 90–110 arasında, 25%-i isə 110-dan artıq qiymətə malik olsunlar. Amerika ali məktəbinin məzununun İQ qiyməti 115, əlaçıların ki, isə 135–140 təşkil edir.

Rəqəmsal intellekt

Rəqəmsal zəka — Rəqəmsal dünyada insanların problemlərə qarşı durmaq və adaptasiya etməsi üçün sosial, emosional və idraki bacarıqlarının cəmidir.

Rəqəmsal zəka hər biri 8 sahədən ibarət olan 3 mərhələni əhatə edir. Rəqəmsal vətəndaşlıq (Digital Citizenship)

Rəqəmsal kreativlik (Digital Creativity)

Rəqəmsal rəqabətlik (Digital Competitiveness)

Rəqəmsal texnologiyaların və medianın effektiv, təhlükəsiz və məsuliyyətlə istifadəsi bacarıqlarıdır.

İdeaların reallaşması üçün yeni məzmun, texnoji həllər və biliklər yaradaraq rəqəmsal ekosistemin bir hissəsi olmaq bacarıqları.

Qlobal problemlərin həlli üçün rəqəmsal texnologiya və medianın istifadəsi isə yeni, innovativ həllər yaratmaq bacarıqları.